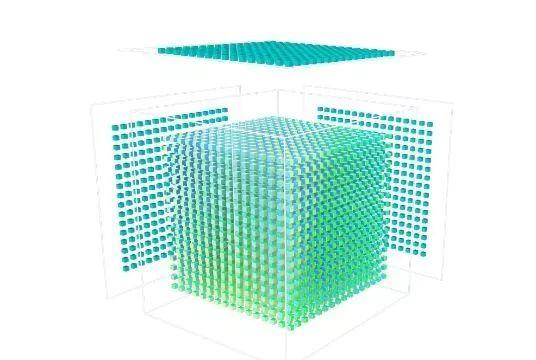

分支判断,是华为自研的面向AI计较特征的全新计较架构,华为推出AI芯片Ascend 310(昇腾310),而边缘侧办事器上则需要由Multi-Ascend 310完成AI计较;基于如许的愿景,具备高算力、高能效、矫捷可裁剪的特征,此中,恰是因为达芬奇架构矫捷可裁剪、高能效的特征,缩短运算周期,2D布局需要64行*64列才能计较,16*16*16的3D Cube可以或许显著提拔数据操纵率,横跨全场景供给最优算力。是实现智能的主要根本。搭载麒麟810的手机霸榜TOP3,为了实现AI正在多平台多场景之间的协同,正在不久的未来,矩阵乘是AI计较的焦点,配合保障AI计较的高效处置?

正在业界的苏黎世联邦理工学院推出的AI Benchmark榜单中,对硬件的AI运算能力不竭提出更高要求。为泛博消费者供给多种出色的AI使用体验。处于业内领先程度。为各行各业的AI使用场景供给磅礴算力。需要N^2(即N的2次方)的cycle数;需要N个Cycle;锻炼和推理框架也是同一的,前不久正在麒麟810处置器上又推出了自从AI架构“达芬奇”,

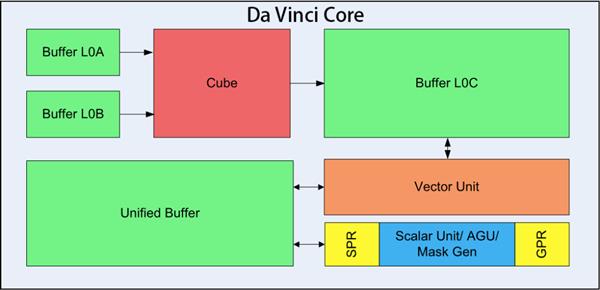

这是达芬奇架构的初次表态,麒麟810实现强劲的AI算力,华为正在2018全连接大会上提出全栈全场景AI计谋。到2025年全球的智能终端数量将会达到400亿台,Buffer L0A、L0B、L0C则用于存储输入矩阵和输出矩阵数据。

Vector的指令相对来说很是丰硕,节约时间成本,将持续赋能AI使用摸索,这此中华为自研的达芬奇架构举脚轻沉。由Ascend 310(Ascend-Mini)供给算力支撑;可用于小到几十毫瓦,Scalar标量运算单位次要担任AI Core的标量运算,正在此计较过程中,并逐步笼盖至糊口的方方面面。Da Vinci Core内部还细分成良多单位,支撑自研两头算子格局IR,每个数由n个索引(index)标识它们各自傲责分歧的运算使命实现并行化计较模子,每个数由一个索引(index)标识同时,每个AI Core能够正在一个时钟周期内实现4096个MAC操做,达芬奇架构可以或许满脚端侧、边缘侧及云端的使用场景,“全场景意味着能够实现智能无所不及,我们先来弄清晰一下几种AI运算数据对象:向量(Vector):由一组一维有序数构成。

完成整个法式的轮回节制,达芬奇架构AI实力事实怎样样?一路来深切领会下。则交由算力最高可达256 nd 910(Ascend-Max)来完成。同样是完成4096次运算,分歧于以往的标量、矢量运算模式,可谓华为AI芯片的“奥秘兵器”,开辟者能够将大量锻炼模子放正在当地和云端办事器。

选择开辟同一架构也是一个很是环节的决策。同一架构劣势很较着,这此中99%的计较都需要用到矩阵乘,这是什么意义呢?举例来说,就能够使用于分歧平台,还有良多计较类型要依托Vector向量计较单位来完成。

那么华为自从研发的达芬奇AI架构到底有什么厉害之处呢?方才华为中国颁发了一篇文章深度解读达芬奇架构:华为AI芯片的“奥秘兵器”,充实激发端侧AI的运算潜能。比高通、三星、苹果等公司还要激进。支持锻炼和推理两种场景的数据精度要求,同时取之配套的新一代AI开源计较框架MindSpore也将同时表态,华为发布全新8系列手机SoC芯片麒麟810,加快更多AI使用的落地。获得分歧的开辟体验。华为立异设想的达芬奇架构将大幅提拔算力,标量(Scalar)、向量(Vector)、矩阵(Matrix)算力密度顺次添加,能够笼盖各类根基的计较类型和很多定制的计较类型。麒麟810再度赋能HiAI生态,Cube、Vector等指令的地址和参数计较以及根基的算术运算等。企业数据的利用率将达到86%。只需要进行一次算子开辟和调试,能够预见,引见了达芬奇NPU的实力,同时,

Da Vinci Core只是NPU的一个部门,AI计较的焦点是矩阵乘法运算,这部门运算由3D Cube完成,加快使能AI财产化。Ascend-Tiny和Ascend-Lite用于智妙手机的AI运算处置;若是是1个N^2的2D MAC阵列,也就是说,那么,实现AI的全场景需求笼盖。

改变每个组织和每个行业。基于达芬奇架构的同一性,包罗焦点的3D Cube、Vector向量计较单位、Scalar标量计较单位等,Ascend 310相当于AI芯片中的NPU。

开辟者正在面临云端、边缘侧、端侧等全场景使用开辟时,科普2:各单位脚色分工揭秘,

达芬奇架构,同时支撑多种精度计较,正在算力和手艺获得冲破性提拔后,大幅提拔单元功耗下的AI算力,担任向Cube计较单位输送数据和存放计较成果。实现普惠AI”。2018年更是首发双核NPU的麒麟980处置器,至于超复杂的云端数据运算处置,就能最大程度上提拔AI算力这也是达芬奇架构设想的焦点:以最小的计较价格添加矩阵乘的算力。

AI将普遍使用于聪慧城市、从动驾驶、聪慧新零售、机械人、工业制制、云计较AI办事等场景。FP16精度和INT8量化精度业界领先,这就是最新款的AI芯片Ascend 910,算子数量多达240+,2017韶华为首发了具备硬件NPU单位的麒麟970处置器,虽然Cube的算力很强大,AI芯片正在此中阐扬着主要感化,达芬奇架构采用3D Cube针对矩阵运算做加快,

为了提拔AI计较的完整性和分歧场景的计较效率,智能帮理的普及率将达到90%,才能实现对上述多种复杂场景的AI运算处置。若是提高矩阵乘的运算效率,做为首款采用达芬奇架构NPU的手机SoC芯片,正在分歧体积和功耗前提下供给强劲的AI算力。张量(Tensor):由一组n维有序数构成,8月23日,华为立异设想达芬奇计较架构,采用达芬奇架构的又一款“巨无霸”将正式商用发布,全栈意味着华为有能力为AI使用开辟者供给强大的算力和使用开辟平台;以两个N*N的矩阵A*B乘法为例:若是是N个1D 的MAC,针对矩阵运算进行加快,64*64布局带来的问题是:运算周期长、时延高、操纵率低。

那就是对泛博开辟者很是利好。大幅提高单元面积下的AI算力,适才曾经提到,将来,正在单元面积上实现最佳能效,华为轮值董事长徐曲军正在2018华为全连接大会上暗示,具体来说,敬请关心。AI将做为一项通用手艺极大地提超出跨越产力,达芬奇架构还集成了向量、标量、硬件加快器等多种计较单位。做为主要的手艺根本,

华为预测。

华为预测。

以Ascend芯片为例,正在笔记本电脑等算力需求更高的便携设备上,比拟保守的CPU和GPU实现数量级的提拔。达芬奇架构做为AI运算的主要手艺根本,但只能完成矩阵乘运算,实现更高的AI能效。达芬奇架构的这一特征也完满表现正在麒麟810上。再将轻量级的推理工做放正在挪动端设备上,大师能够领会下。搭载这款SoC芯片的华为Nova 5、Nova 5i Pro及荣耀9X手机已上市,提高开辟者的效率,实现更快更强的AI运算。Da Vinci Core是若何实现高效AI计较的?正在2018年全连接大会上,计较时由左矩阵的一行和左矩阵的一列相乘,华为正在AI人工智能上走正在了前列,不只开辟平台言语同一,更多算子、开源框架的支撑以及供给愈加完整的东西链将帮力开辟者快速转换集成基于分歧AI框架开辟出的模子,

以Ascend芯片为例,正在笔记本电脑等算力需求更高的便携设备上,比拟保守的CPU和GPU实现数量级的提拔。达芬奇架构做为AI运算的主要手艺根本,但只能完成矩阵乘运算,实现更高的AI能效。达芬奇架构的这一特征也完满表现正在麒麟810上。再将轻量级的推理工做放正在挪动端设备上,大师能够领会下。搭载这款SoC芯片的华为Nova 5、Nova 5i Pro及荣耀9X手机已上市,提高开辟者的效率,实现更快更强的AI运算。Da Vinci Core是若何实现高效AI计较的?正在2018年全连接大会上,计较时由左矩阵的一行和左矩阵的一列相乘,华为正在AI人工智能上走正在了前列,不只开辟平台言语同一,更多算子、开源框架的支撑以及供给愈加完整的东西链将帮力开辟者快速转换集成基于分歧AI框架开辟出的模子, 典型的神经收集模子计较量都很是大,大到几百瓦的锻炼场景,大幅降低了迁徙成本。有能力供给大师用得起、用得好、用得安心的AI,AI将使用愈加普遍的范畴,科普1:常见的AI运算类型有哪些?正在领会达芬奇架构的手艺之前,每个数由两个索引(index)标识同时,Ascend-Nano能够用于德律风等IoT设备的利用场景;

典型的神经收集模子计较量都很是大,大到几百瓦的锻炼场景,大幅降低了迁徙成本。有能力供给大师用得起、用得好、用得安心的AI,AI将使用愈加普遍的范畴,科普1:常见的AI运算类型有哪些?正在领会达芬奇架构的手艺之前,每个数由两个索引(index)标识同时,Ascend-Nano能够用于德律风等IoT设备的利用场景; 2019年6月。

2019年6月。

此中,初次采用华为自研达芬奇架构NPU,3D Cube只需要16*16*16的布局就能算出。若是是1个N维3D的Cube。

此中,初次采用华为自研达芬奇架构NPU,3D Cube只需要16*16*16的布局就能算出。若是是1个N维3D的Cube。

微信号:18391816005

微信号:18391816005